Críticas

Vea también el vídeo en YouTube: https://youtu.be/s_5dbmAQHko

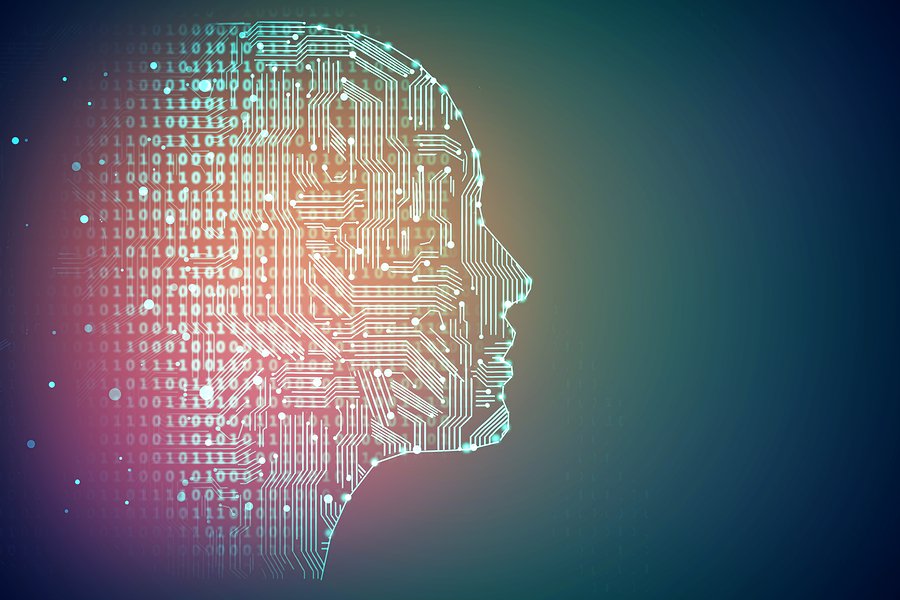

Las principales críticas a la inteligencia artificial tienen que ver con su capacidad de imitar por completo a un ser humano. Sin embargo, hay expertos en el tema que indican que ningún humano individual tiene capacidad para resolver todo tipo de problemas, y autores como Howard Gardner han teorizado que existen inteligencias múltiples. Un sistema de inteligencia artificial debería resolver problemas por lo que es fundamental en su diseño la delimitación de los tipos de problemas que resolverá y las estrategias y algoritmos que utilizará para encontrar la solución.

En los humanos, la capacidad de resolver problemas tiene dos aspectos: los aspectos innatos y los aspectos aprendidos. Los aspectos innatos permiten, por ejemplo, almacenar y recuperar información en la memoria, mientras que en los aspectos aprendidos reside el saber resolver un problema matemático mediante el algoritmo adecuado. Del mismo modo que un humano debe disponer de herramientas que le permitan solucionar ciertos problemas, los sistemas artificiales deben ser programados de modo tal que puedan llegar a resolverlos.

Muchas personas consideran que el test de Turing ha sido superado, citando conversaciones en que al dialogar con un programa de inteligencia artificial para chat no saben que hablan con un programa. Sin embargo, esta situación no es equivalente a un test de Turing, que requiere que el participante esté sobre aviso de la posibilidad de hablar con una máquina.

Otros experimentos mentales como la Habitación china, de John Searle, han mostrado cómo una máquina podría simular pensamiento sin realmente poseerlo, pasando el test de Turing sin siquiera entender lo que hace, tan solo reaccionando de una forma concreta a determinados estímulos (en el sentido más amplio de la palabra). Esto demostraría que la máquina en realidad no está pensando, ya que actuar de acuerdo con un programa preestablecido sería suficiente. Si para Turing el hecho de engañar a un ser humano que intenta evitar que le engañen es muestra de una mente inteligente, Searle considera posible lograr dicho efecto mediante reglas definidas a priori.

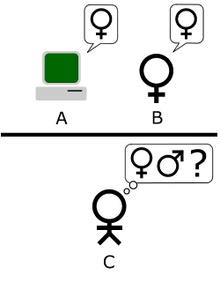

Uno de los mayores problemas en sistemas de inteligencia artificial es la comunicación con el usuario. Este obstáculo es debido a la ambigüedad del lenguaje, y se remonta a los inicios de los primeros sistemas operativos informáticos. La capacidad de los humanos para comunicarse entre sí implica el conocimiento del lenguaje que utiliza el interlocutor. Para que un humano pueda comunicarse con un sistema inteligente hay dos opciones: o bien que el humano aprenda el lenguaje del sistema como si aprendiese a hablar cualquier otro idioma distinto al nativo, o bien que el sistema tenga la capacidad de interpretar el mensaje del usuario en la lengua que el usuario utiliza. También hay desperfectos en las instalaciones de los mismos.

Un humano, durante toda su vida, aprende el vocabulario de su lengua nativa o materna, siendo capaz de interpretar los mensajes (a pesar de la polisemia de las palabras) utilizando el contexto para resolver ambigüedades. Sin embargo, debe conocer los distintos significados para poder interpretar, y es por esto que lenguajes especializados y técnicos son conocidos solamente por expertos en las respectivas disciplinas. Un sistema de inteligencia artificial se enfrenta con el mismo problema, la polisemia del lenguaje humano, su sintaxis poco estructurada y los dialectos entre grupos.

Los desarrollos en inteligencia artificial son mayores en los campos disciplinares en los que existe mayor consenso entre especialistas. Un sistema experto es más probable que sea programado en física o en medicina que en sociología o en psicología. Esto se debe al problema del consenso entre especialistas en la definición de los conceptos involucrados y en los procedimientos y técnicas a utilizar. Por ejemplo, en física hay acuerdo sobre el concepto de velocidad y cómo calcularla. Sin embargo, en psicología se discuten los conceptos, la etiología, la psicopatología y cómo proceder ante cierto diagnóstico. Esto dificulta la creación de sistemas inteligentes porque siempre habrá desacuerdo sobre la forma en que debería actuar el sistema para diferentes situaciones. A pesar de esto hay grandes avances en el diseño de sistemas expertos para el diagnóstico y toma de decisiones en el ámbito médico y psiquiátrico (Adaraga Morales, Zaccagnini Sancho, 1994).

Al desarrollar un robot con inteligencia artificial se debe tener cuidado con la autonomía,hay que tener cuidado en no vincular el hecho de que el robot interaccione con seres humanos a su grado de autonomía. Si la relación de los humanos con el robot es de tipo maestro esclavo, y el papel de los humanos es dar órdenes y el del robot obedecerlas, entonces sí cabe hablar de una limitación de la autonomía del robot. Pero si la interacción de los humanos con el robot es de igual a igual, entonces su presencia no tiene por qué estar asociada a restricciones para que el robot pueda tomar sus propias decisiones.

Stephen Hawking advirtió sobre los peligros de la inteligencia artificial y lo consideró una amenaza para la supervivencia de la humanidad.

Si miramos hacia el futuro, no hay límites a lo podemos lograr en este campo [I.A.]. No hay ninguna ley física que impida que las partículas en un sistema de inteligencia artificial se re-ordenen a sí mismas para realizar cálculos más complejos de los que somos capaces de hacer los seres humanos. Es perfectamente posible que se produzca un salto radical e inesperado. Como Irving Good ya apuntó en 1965, un sistema de inteligencia artificial puede decidir mejorar su propio diseño por su cuenta, dando lugar a lo que Vernor Vinge denominó una singularidad, o lo que Johny Depp llama Trascendencia en la reciente película que protagoniza.

No es difícil imaginar una tecnología semejante dominando completamente los mercados financieros, sobrepasando los diseños de sus propios creadores, manipulando líderes, o encontrando maneras de construir armas que no seríamos capaces ni de comprender. Aunque el impacto a corto plazo de un sistema de inteligencia artificial depende de quien lo controla, la cuestión a largo plazo es si un sistema así puede ser controlado por seres humanos.

Estamos ante un futuro de incalculables posibilidades, oportunidades y riesgos. Es lógico pensar que los científicos están tomando todas las precauciones para asegurar el mejor resultado posible, ¿verdad? Pues no es así. ¿Si una civilización del espacio exterior nos enviara un mensaje diciendo: «Llegamos en unos años», nuestra respuesta sería: «¡Ok! Avisadnos cuando estéis llegando para dejar las luces encendidas»? Probablemente no, pero eso es más o menos lo que está ocurriendo con la inteligencia artificial. Aunque sabemos que la I.A. tiene el potencial para ser el mayor acierto, o el peor error de la humanidad, no se están investigando seriamente sus implicaciones Las únicas organizaciones que están estudiando esto son el Centro Cambridge para el estudio del riesgo existencial, el Instituto para el futuro de la humanidad, el Centro de Investigación de Inteligencia Artificial, o el Instituto Vida Futura. Todos nosotros deberíamos preguntarnos desde hoy mismo qué puede hacerse para aprovechar lo mejor de la inteligencia artificial y evitar lo peor.

Stephen Hawking